Standardfehler

Van Wikipedia, de gratis encyclopedie

Van Wikipedia, de gratis encyclopedie

Der Standardfehler oder Stichprobenfehler ist ein Streuungsmaß für eine Schätzfunktion für einen unbekannten Parameter der Grundgesamtheit. Der Standardfehler ist definiert als die Standardabweichung der Schätzfunktion, , das heißt also die positive Quadratwurzel aus der Varianz[1]. In den Naturwissenschaften und der Metrologie wird auch der durch den GUM geprägte Begriff Standardunsicherheit verwendet.

Bei einem erwartungstreuen Schätzer ist daher der Standardfehler ein Maß für die durchschnittliche Abweichung des geschätzten Parameterwertes vom wahren Parameterwert. Je kleiner der Standardfehler ist, desto genauer kann der unbekannte Parameter mit Hilfe der Schätzfunktion geschätzt werden. Der Standardfehler hängt unter anderem ab von

- dem Stichprobenumfang und

- der Varianz in der Grundgesamtheit.

Allgemein gilt: Je größer der Stichprobenumfang, desto kleiner der Standardfehler; je kleiner die Varianz, desto kleiner der Standardfehler.

Eine wichtige Rolle spielt der Standardfehler auch bei der Berechnung von Schätzfehlern, Konfidenzintervallen und Teststatistiken.

Interpretation[Bearbeiten | Quelltext bearbeiten]

Der Standardfehler liefert eine Aussage über die Güte des geschätzten Parameters. Je mehr Einzelwerte es gibt, desto kleiner ist der Standardfehler, und umso genauer kann der unbekannte Parameter geschätzt werden. Der Standardfehler macht die gemessene Streuung (Standardabweichung) zweier Datensätze mit unterschiedlichen Stichprobenumfängen vergleichbar, indem er die Standardabweichung auf den Stichprobenumfang normiert.

Wird mit Hilfe von mehreren Stichproben der unbekannte Parameter geschätzt, so werden die Ergebnisse von Stichprobe zu Stichprobe variieren. Natürlich stammt diese Variation nicht von einer Variation des unbekannten Parameters (denn der ist fix), sondern von Zufallseinflüssen, z. B. Messungenauigkeiten. Der Standardfehler ist die Standardabweichung der geschätzten Parameter in vielen Stichproben. Im Allgemeinen gilt: Für eine Halbierung des Standardfehlers ist eine Vervierfachung des Stichprobenumfangs nötig.

Im Gegensatz dazu bildet die Standardabweichung die in einer Grundgesamtheit tatsächlich vorhandene Streuung ab, die auch bei höchster Messgenauigkeit und unendlich vielen Einzelmessungen vorhanden ist (z. B. bei Gewichtsverteilung, Größenverteilung, Monatseinkommen). Sie zeigt, ob die Einzelwerte nahe beieinander liegen oder eine starke Spreizung der Daten vorliegt.

Beispiel[Bearbeiten | Quelltext bearbeiten]

Angenommen, man untersucht die Grundgesamtheit von Kindern, die Gymnasien besuchen, hinsichtlich ihrer Intelligenzleistung. Der unbekannte Parameter ist also die mittlere Intelligenzleistung der Kinder, die ein Gymnasium besuchen. Wenn nun zufällig aus dieser Grundgesamtheit eine Stichprobe des Umfanges (also mit Kindern) gezogen wird, dann kann man aus allen Messergebnissen den Mittelwert berechnen. Wenn nun nach dieser Stichprobe noch eine weitere, zufällig gezogene Stichprobe mit der gleichen Anzahl von Kindern gezogen und deren Mittelwert ermittelt wird, so werden die beiden Mittelwerte nicht exakt übereinstimmen. Zieht man noch eine Vielzahl weiterer zufälliger Stichproben des Umfanges , dann kann die Streuung aller empirisch ermittelten Mittelwerte um den Mittelwert der Grundgesamtheit ermittelt werden. Diese Streuung ist der Standardfehler. Da der Mittelwert der Stichprobenmittelwerte der beste Schätzer für den Mittelwert der Grundgesamtheit ist, entspricht der Standardfehler der Streuung der empirischen Mittelwerte um den Mittelwert der Grundgesamtheit. Er bildet nicht die Intelligenzstreuung der Kinder, sondern die Genauigkeit des errechneten Mittelwerts ab.

Notation[Bearbeiten | Quelltext bearbeiten]

Für den Standardfehler benutzt man verschiedene Bezeichnungen um ihn von der Standardabweichung der Grundgesamtheit zu unterscheiden und um zu verdeutlichen, dass es sich um die Streuung des geschätzten Parameters von Stichproben handelt:

- ,

- oder

- .

Konfidenzintervalle und Tests[Bearbeiten | Quelltext bearbeiten]

Der Standardfehler spielt auch eine wichtige Rolle bei Konfidenzintervallen und Tests. Wenn die Schätzfunktion erwartungstreu und zumindest approximativ normalverteilt () ist, dann ist

- .

Auf dieser Basis lassen sich -Konfidenzintervalle für den unbekannten Parameter angeben:

bzw. Tests formulieren, z. B. ob der Parameter einen bestimmten Wert annimmt:

- vs.

und die Teststatistik ergibt sich zu:

- .

ist das -Quantil der Standardnormalverteilung und sind auch der kritische Wert für den formulierten Test. In der Regel muss aus der Stichprobe geschätzt werden, so dass

gilt, wobei die Anzahl der Beobachtungen ist. Für kann die t-Verteilung durch die Standardnormalverteilung approximiert werden.

Standardfehler des arithmetischen Mittels[Bearbeiten | Quelltext bearbeiten]

Der Standardfehler des arithmetischen Mittels ist gleich

- ,

wobei die Standardabweichung einer einzelnen Messung bezeichnet. Der Standardfehler des Mittelwertes kann entweder mit obiger Formel und Schätzung von berechnet werden, oder direkt mithilfe des Bootstrapping-Verfahrens oder der Jackknife-Methode.

Herleitung[Bearbeiten | Quelltext bearbeiten]

Der Mittelwert einer Stichprobe vom Umfang ist definiert durch

Betrachtet man die Schätzfunktion

mit unabhängigen, identisch verteilten Zufallsvariablen mit endlicher Varianz , so ist der Standardfehler definiert als die Wurzel aus der Varianz von . Man berechnet unter Verwendung der Rechenregeln für Varianzen und der Gleichung von Bienaymé:

woraus die Formel für den Standardfehler folgt. Falls gilt, so folgt analog

- .

Schätzung von σ[Bearbeiten | Quelltext bearbeiten]

Da in den Standardfehler die Standardabweichung der Grundgesamtheit eingeht, muss für eine Schätzung des Standardfehlers die Standardabweichung in der Grundgesamtheit mit einem möglichst erwartungstreuen Schätzer derselben geschätzt werden.

Unterstellt man eine Stichprobenverteilung, so kann der Standardfehler anhand der Varianz der Stichprobenverteilung berechnet werden:

- bei der Binomialverteilung mit Parametern

- ,

- bei der Exponentialverteilung mit Parameter (Erwartungswert = Standardabweichung = ):

- und bei der Poisson-Verteilung mit Parameter (Erwartungswert = Varianz = ):

Dabei bezeichnen

- die Standardfehler der jeweiligen Verteilung, und

- den Stichprobenumfang.

Soll der Standardfehler für den Mittelwert geschätzt werden, dann wird die Varianz mit der korrigierten Stichprobenvarianz geschätzt.

Beispiel[Bearbeiten | Quelltext bearbeiten]

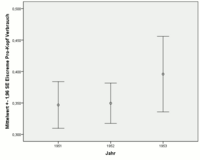

Für die Eiscreme-Daten[2][3] wurde für den Pro-Kopf-Verbrauch von Eiscreme (gemessen in Pint) das arithmetische Mittel, dessen Standardfehler und die Standardabweichung für die Jahre 1951, 1952 und 1953 berechnet.

| Jahr | Mittelwert | Standardfehler des Mittelwerts | Standard- abweichung | Anzahl der Beobachtungen |

|---|---|---|---|---|

| 1951 | 0,34680 | 0,01891 | 0,05980 | 10 |

| 1952 | 0,34954 | 0,01636 | 0,05899 | 13 |

| 1953 | 0,39586 | 0,03064 | 0,08106 | 7 |

Für die Jahre 1951 und 1952 sind die geschätzten Mittelwerte und Standardabweichungen sowie die Beobachtungszahlen etwa gleich. Deswegen ergeben die geschätzten Standardfehler auch etwa den gleichen Wert. Im Jahr 1953 sind zum einen die Beobachtungszahlen geringer als auch die Standardabweichung größer. Daher ist der Standardfehler fast doppelt so groß wie die Standardfehler aus den Jahren 1951 und 1952.

Die grafische Darstellung kann mittels eines Fehlerbalkendiagramms erfolgen. Rechts werden die 95 %-Schätzintervalle für die Jahre 1951, 1952 und 1953 dargestellt. Wenn die Stichprobenfunktion zumindest approximativ normalverteilt ist, dann sind die 95 %-Schätzintervalle gegeben durch mit und die Stichprobenmittelwerte und die Stichprobenvarianzen.

Auch hier sieht man deutlich, dass der Mittelwert 1953 ungenauer geschätzt werden kann als die Mittelwerte von 1951 und 1952 (längerer Balken für 1953).

Endlich große Population[Bearbeiten | Quelltext bearbeiten]

Bei einer endlich großen Population mit Größe und Stichprobengröße ist die Varianz des geschätzten Mittelwertes[4] Die Varianz des Mittelwert-Schätzers ist somit Null, wenn .

Standardfehler der Regressionskoeffizienten im einfachen Regressionsmodell[Bearbeiten | Quelltext bearbeiten]

Im klassischen Regressionsmodell für die einfache lineare Regression wird vorausgesetzt, dass

- die Störterme normalverteilt sind,

- die Störterme unabhängig sind und

- die Werte fix sind (also keine Zufallsvariablen),

wobei die gemachten Beobachtungen durchläuft. Für die Schätzfunktionen

- und

ergibt sich dann

- und .

Die Standardfehler der Regressionskoeffizienten ergeben sich zu

und

- .

Beispiel: Für die Eiscreme-Daten[2][3] wurde für den Pro-Kopf-Verbrauch von Eiscreme (gemessen in halbe Liter) eine einfache lineare Regression mit der mittleren Wochentemperatur (in Fahrenheit) als unabhängige Variable durchgeführt. Die Schätzung des Regressionsmodells ergab:

- .

| Modell | Nicht standardisierte Koeffizienten | Standardisierte Koeffizienten | T | Sig. | |

|---|---|---|---|---|---|

| Regressionskoeffizienten | Standardfehler | ||||

| Konstante | 0,20686 | 0,02470 | 8,375 | 0,000 | |

| Temperatur | 0,00311 | 0,00048 | 0,776 | 6,502 | 0,000 |

Zwar ist der geschätzte Regressionskoeffizient für die mittlere Wochentemperatur sehr klein, jedoch ergab der geschätzte Standardfehler einen noch kleineren Wert. Die Genauigkeit, mit der der Regressionskoeffizient geschätzt wird, ist gut 6,5 mal so klein wie der Koeffizient selbst.

Zusammenhang mit der Log-Likelihood[Bearbeiten | Quelltext bearbeiten]

Der Ausdruck wird auch als Standardfehler des Maximum-Likelihood-Schätzers bezeichnet, wobei die Log-Likelihood-Funktion und die beobachtete Fisher-Information darstellt (die Fisher-Information an der Stelle des ML-Schätzers ).[5]

Siehe auch[Bearbeiten | Quelltext bearbeiten]

Einzelnachweise[Bearbeiten | Quelltext bearbeiten]

- ↑ Eric W. Weisstein: Standard Error. Abgerufen am 7. November 2021 (englisch).

- ↑ a b Koteswara Rao Kadiyala (1970): Testing for the independence of regression disturbances. In: Econometrica, 38, 97–117.

- ↑ a b Eiscreme Daten. In: Data and Story Library, abgerufen am 16. Februar 2010

- ↑ Quenouille, M. (2014). Introductory Statistics. Niederlande: Elsevier Science. https://books.google.de/books?id=anHiBQAAQBAJ&pg=PA208

- ↑ Supplement: Loglikelihood and Confidence Intervals. Abgerufen am 14. Juli 2021.